Autonomes Fahren: Wenn die Ethik im Stau stehtUnderstanding Digital Capitalism III | Teil 10

16.4.2018 • Gesellschaft – Text: Timo Daum, Illustration / Infografik: Susann Massute

Die vergangenen Monate waren überschattet von mehreren Unfällen mit Todesfolge, in die autonome Fahrzeuge verwickelt waren. Timo Daum erklärt den Konflikt zwischen Ethik und Fortschritt, bestellt einen Uber für Immanuel Kant und beginnt seine Reise in einem autonomen Bus in Berlin.

Foto: BVG / Diana Stein

Seit dem 26. März sind in Berlin vier autonom fahrende, führerlose Elektro-Kleinbusse im Regelbetrieb unterwegs. Auf dem Gelände der Charité und dem Campus des Virchow-Klinikums können Mitarbeiter, Patienten und Besucher kostenlos einsteigen. Weltweit ist dieser Bus, der EZ10 des Herstellers EasyMile, bereits in 20 Ländern im Einsatz. Wenn es um selbstfahrende Autos geht, neigt die Öffentlichkeit dazu, sich auf Entwicklungen für Privatfahrzeuge für Einzelpersonen zu konzentrieren, doch es gibt auch einige bedeutende Fortschritte in anderen Kategorien wie eben bei Shuttle-Bussen. Es scheint wahrscheinlich, dass sich der vollständig autonome (dauerhaft fahrerlose) Fahrzeugbetrieb in Deutschland, anders als etwa in den USA, zuerst in Nischen etablieren wird, in denen feste Fahrwege auf Privatgelände zurückgelegt werden. Hier sind die Einsatzbedingungen klar, die Wahrscheinlichkeit schwerwiegender Unfälle ist geringer und die Akzeptanz damit höher.

Autonome Unfälle

Bis dato sind drei tödliche Unfälle mit autonomen Fahrzeugen bekannt geworden. Am 7. Mai 2016 kam es auf einer Schnellstraße in Florida zu einem Zwischenfall, bei dem der 40jährige Joshua Brown aus Ohio am Steuer seines Tesla Model S starb, als das Auto ungebremst in einen Sattelschlepper hineinfuhr, nachdem dieser ihm die Vorfahrt genommen hatte. Das System hatte die helle Plane des LKW im Gegenlicht der untergehenden Sonne als Teil des Himmels analysiert. Das war der erste Todesfall am Steuer eines halbautonomen Fahrzeugs; zum Zeitpunkt des Unfalls befand sich der Wagen im „Autopilot“-Modus, und weder der Fahrer noch die KI hatten eine Bremsung eingeleitet. Die National Highway Traffic Safety Administration (NHTSA) strengte eine Untersuchung an, deren Ergebnisse im Februar 2017 veröffentlicht wurden. Fazit: Die Software habe einwandfrei gearbeitet, somit sei Tesla an Browns Tod nicht mitschuldig.

„Wir wollen diese Technologien fördern“, kommentierte Bryan Thomas, der Kommunikationsdirektor der NHTSA. „Sie werden Leben retten und Crashs dramatisch reduzieren, aber Innovation ist eine holprige Straße.“ Tesla aktualisierte nach dem Todesfall in Florida die Software – zum Erkennen von Hindernissen verwendet das System jetzt mehr Daten des eingebauten Radar statt die der Kamera. Das System ist lernfähig, der gleiche Fehler dürfte nicht noch einmal passieren, ganz anders allerdings beim Menschen: Der Einzelne lernt zwar möglicherweise aus Fehlern, aber die Menschheit als Ganzes lernt einfach nicht dazu. Stirbt ein Senior, nimmt er Millionen Kilometer Fahrerfahrung mit ins Grab – nicht sehr smart.

Beim zweiten bekanntgewordenen Unfall – am 19. März 2018 im US-Bundesstaat Arizona – wurde eine plötzlich auftauchende Fußgängerin von einem Volvo erfasst, einem Auto, das Teil der autonomen Flotte von Uber war. Die Situation war laut den beiden Herstellern der optischen Systeme von diesen klar erkannt worden, das Auto leitete trotzdem keine Notbremsung ein und war außerdem zu schnell unterwegs. Der dritte Unfall ereignete sich nur wenige Tage danach, am 23. März in Mountain View, Kalifornien. Auch hier war das „Autopilot“ des Tesla aktiv und hat – das belegt die Auswertung des Bordcomputers – sogar vor einem möglichen Zusammenstoß mit einem Betonpoller gewarnt. Der Tesla ging in Flammen auf, der Fahrer starb.

Die eigentliche Frage ist, wer oder was in solchen Situationen wirklich verantwortlich ist und welche ethischen Regeln der Fahr-Software zugrunde liegen sollen. Reflexhaft fallen vielen zum autonomen Fahren knifflige Situationen ein, die unsere moralischen Werte und ethischen Vorstellungen herausfordern. So fragen etwa die Mitglieder das technikkritische Kollektiv Capulcu in ihrem Buch „DISRUPT! – Widerstand gegen den technologischen Angriff“: „Wen soll der selbst-lernende Algorithmus tot fahren, wenn eine Kollision als unvermeidbar eingestuft wird? Den 18-jährigen Radfahrer oder die 67-jährige Fußgängerin?“ Wir geben eine Antwort auf diese Frage.

Doch zunächst ein Blick zurück in die Anfangszeit des Automobils, als sich schon einmal ähnliche Fragen stellten.

Die Erfindung des Zebrastreifen oder: Sind Automobile wilde Tiere?

Detroit reguliert den Autoverkehr zuerst.

Zu Beginn des letzten Jahrhunderts sahen Straßen gänzlich anders aus als heute: Es gab keine Markierungen, Verkehrszeichen oder gar Ampeln. Fußgänger überquerten immer und überall die Straße, Kinder spielten auf ihr. Herannahende Pferdefuhrwerke und die ersten Autos waren langsam und laut genug, um rechtzeitig auf sich aufmerksam zu machen. Das änderte sich rasch, und die Stadt Detroit wurde zur Vorreiterin einer Regulierung des zunehmenden Verkehrs: Das erste Stoppschild der Welt, die ersten Ampeln und Zebrastreifen erblickten in der Motor City erstmals das Licht der Welt. Angesichts erster tragischer Unfälle wurde das Auto zum Gegenstand einer grundlegenden ethischen Debatte, mit der sich auch die Gerichte beschäftigten. Diese hatten darüber zu befinden, ob das Automobil von Natur aus böse sei und ob ihm ein eigener Wille zugeschrieben werden könne. Ein Urteil des Berufungsgericht in Georgia aus dieser Zeit stellte fest, dass solche Fahrzeuge zwar nicht bösartig seien, aber „als gefährliche Wildtiere eingestuft werden müssen“, schreibt der Technikjournalist Bill Loumis in einem Artikel. Aus diesem Grund sollten die geltenden Gesetze für den Besitz exotischer Tiere angewendet werden.

Und heute? Lorena Jaume-Palasí sieht im Zusammenhang mit Künstlicher Intelligenz eine ähnliche Situation vorliegen. Das Mitglied des Beirats für KI und Big Data der spanischen Regierung erklärt, aufgrund fehlender Vertrautheit erscheine KI magisch und führe uns dazu, alte Debatten wieder zu eröffnen. In einem Zeitungsartikel schreibt sie, es mache auch heute keinen Sinn, über Willen, Güte oder Boshaftigkeit von Algorithmen zu debattieren, auch wenn diese zunächst beeindrucken, erfreuen oder verängstigen können.

Das Trolley-Problem: Jeremy Bentham oder Immanuel Kant?

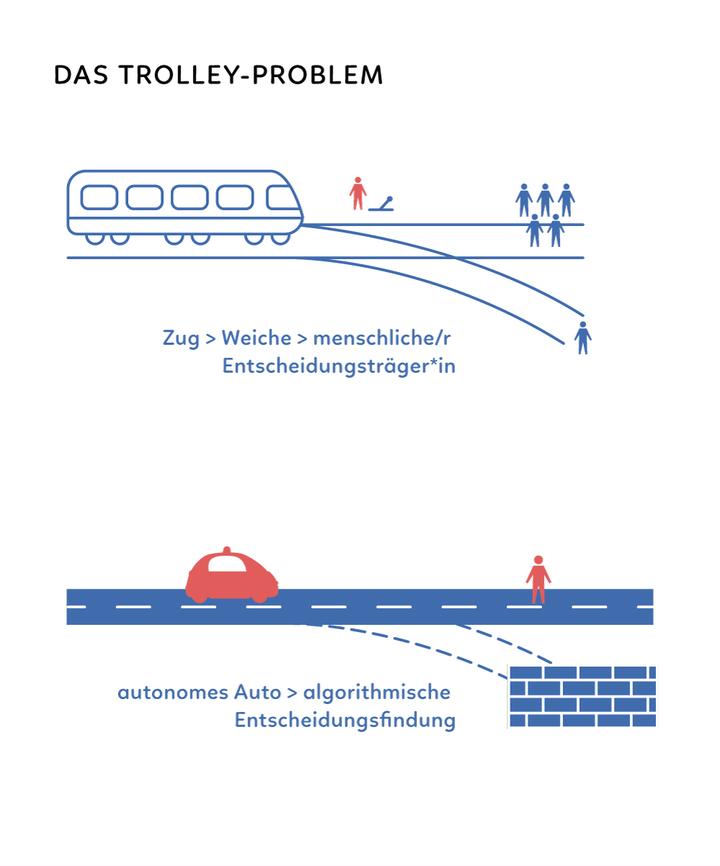

Das Trolley-Problem ist eine klassische Fragestellung der Ethik. Dabei geht die gängigste Variante folgendermaßen: Ein Zug fährt mit hoher Geschwindigkeit auf eine Weiche zu. Auf dem Gleis sind fünf Menschen festgebunden. Der Zug kann nicht mehr bremsen. Auf dem Nachbargleis ist eine Person festgebunden. Eine Testperson hätte noch Zeit, aktiv einzugreifen, die Weiche umzustellen und damit die Person auf dem Nebengleis zu opfern, um die fünf auf dem Hauptgleis zu retten. Soll sie aktiv eingreifen, zum Mörder der einen Person und zum Retter der fünf anderen werden? Oder soll sie nicht eingreifen, sich damit nicht schuldig machen, niemanden opfern, aber auch mehr Tote in Kauf nehmen? Im Prinzip gibt es zwei Lager. Auf der einen Seite sind die Utilitaristen, die sich gern auf den britischen Philosophen Jeremy Bentham berufen: Der Gesamtschaden soll minimiert werden, eine Aufrechnung soll stattfinden, der größte Nutzen bestimmt werden, und dann dementsprechend gehandelt werden. Auch wenn dies dazu führt, dass Unschuldige zu Tode kommen. Dieser eher amerikanischen Tradition steht die kontinentaleuropäische Sichtweise gegenüber, bei der mit Verweis auf Immanuel Kant betont wird: Wir sollten ethischen Prinzipien folgen, z.B. „Du sollst nicht töten!“

Spontan mag Bentham eher überzeugen (ein Toter ist besser als fünf Tote!). Sein Ansatz führt aber rasch zu wirklich kniffligen Entscheidungen, die wiederum schwer akzeptierbar sind:

- Was ist, wenn auf beiden Gleisen jeweils nur eine Person liegt?

- Was, wenn auf dem einen Gleis ein zum Tode verurteilte Schwerverbrecher und auf dem anderen eine erstklassige Neurochirurgin festgebunden sind?

- Was ist etwa, wenn der einzelne Gefesselte eine Fernbedienung für die Weiche hat, er sich also selbst töten müsste?

Die Benthamschen Überlegungen – der Versuch der Schadensminimierung durch Aufrechnung – führt in Teufels Küche. Bentham hört sich gut für BWLer an, ist aber außer vielleicht in Nordkorea oder Nordamerika nicht mehrheitsfähig. Also: Kant!

Autonomes Fahre: Status quo

Der Mensch am Weichensteller wird hier ersetzt durch die Programmierung des Algorithmus. Die Entscheidung wird also im Vorhinein getroffen und in die Software implementiert. Die dem Trolley-Problem analoge Situation könnte folgendermaßen aussehen: Ein Fußgänger tritt plötzlich auf die Straße, das Auto kann nicht mehr bremsen und hat nur die Wahl zwischen geradeaus weiterfahren und den Fußgänger töten oder ausweichen und in eine Mauer fahren und damit den Fahrer töten. Aber:

- Was ist, wenn es sich um ein Kind handelt?

- Was ist, wenn die Person auf einem Zebrastreifen quert, also „im Recht“ ist?

- Was ist, wenn mehrere Personen betroffen sind?

Mit Kant sollte die Software zunächst eine Bremsung versuchen, dann ein Ausweichmanöver und dabei den Totalschaden des Fahrzeugs und sogar Verletzungen der Insassen in Kauf nehmen, falls das Leben des Fußgängers gerettet werden kann. Falls das nicht möglich ist, muss der Fußgänger dran glauben.

Wer soll nun diese Entscheidungen fällen? Der Autobesitzer, der Hersteller, die Versicherung, der Gesetzgeber? Iyad Rahwan vom MIT Media Lab, sagt in einem TED-Talk: „In der Regel lösen wir diese Art von sozialen Dilemmata mithilfe von Regulierung, so dass Regierungen oder Gemeinschaften zusammenkommen und gemeinsam entscheiden, welche Art von Ergebnissen sie wollen und welche Einschränkungen für das individuelle Verhalten sie implementieren müssen.“

Ethik-Kommission Deutschland: Gesetzgebung à la Kant

Am 30. März 2017 wurde im Bundestag eine Novelle des Straßenverkehrsgesetztes verabschiedet, mit der hochautomatisiertes Fahren ermöglicht werden soll. Im Auftrag der Bundesregierung hat eine Kommission ethische Leitlinien für das autonome Fahren erarbeitet: Ziele, die in die Software implementiert werden sollen, sind Rücksichtnahme, vorausschauende Fahrweise oder die Berücksichtigung der Verletzlichkeit von anderen VerkehrsteilnehmerInnen. Die Vermeidung von Personenschäden ist dabei vorrangig, erst danach kommen die Vermeidung von Sachschäden und weitere Kriterien ins Spiel.

„Die dem Menschen vorbehaltene Verantwortung verschiebt sich bei automatisierten und vernetzten Fahrsystemen vom Autofahrer auf die Hersteller und Betreiber der technischen Systeme und die infrastrukturellen, politischen und rechtlichen Entscheidungsinstanzen.“

Bei unausweichlichen Unfallsituationen ist jede Qualifizierung von Menschen nach persönlichen Merkmalen (Alter, Geschlecht, körperliche oder geistige Konstitution) unzulässig. Und weiter: „Die dem Menschen vorbehaltene Verantwortung verschiebt sich bei automatisierten und vernetzten Fahrsystemen vom Autofahrer auf die Hersteller und Betreiber der technischen Systeme und die infrastrukturellen, politischen und rechtlichen Entscheidungsinstanzen.“ Die Haftung geht im Sinne einer Produkthaftung auf die Hersteller über, diese sollen zudem zur ständigen Optimierung und Überwachung bereits ausgelieferter Software verpflichtet werden. Öffentliche Kontrolle und Zulassung der Software sind weitere Eckpunkte des Papiers – Algorithmen bzw. deren kommerzielle Betreiber sollen rechenschaftspflichtig sein. In den Leitlinien heißt es dazu: „Die Öffentlichkeit hat einen Anspruch auf eine hinreichend differenzierte Aufklärung über neue Technologien und ihren Einsatz.“

Ab wann soll eine Technologie zugelassen werden, auch wenn sie noch nicht perfekt ist?

Werden diese Prinzipien in den Fahrzeugen umgesetzt, wird der Verkehr nicht nur insgesamt sicherer, sondern auch weniger aggressiv. Ein autonomes Fahrzeug wird nie mit Absicht eine Radfahrerin schneiden, einem Fußgänger die Vorfahrt nehmen, noch schnell bei Dunkelgelb Gas geben oder sonstige Rüpeleien begehen, die in unserem nicht-algorithmischen Verkehr alltäglich sind. An die Stelle des Rechts des Stärkeren könnte die Stärkung bislang benachteiligter und schwächerer Verkehrsteilnehmerinnen treten. Die wirklich interessante Frage: Ab wann soll eine Technologie zugelassen werden, auch wenn sie noch nicht perfekt ist? Hier müssten die Gesetzgeber abwägen zwischen der Menschenleben, die durch die Technologie gerettet werden können, gegen diejenigen, die Opfer einer noch nicht ausgereiften Technik werden. In den USA ist man dabei deutlich waghalsiger als etwa in Deutschland. Autonome Shuttles, wie die, die jetzt in Berlin verkehren, sind vielleicht der bessere Ansatz.

Timo Daum hat zum Thema „Auto im Digitalen Kapitalismus“ eine Studie bei der Rosa Luxemburg Stiftung veröffentlicht (PDF). Auf der Re:Publica (2. bis 4. Mai 2018) gibt es zu diesem Thema ein Panel von Timo und Verena Dauerer.

Quellen und Links

- Peter D. Norton, Fighting Traffic. The Dawn of the Motor Age in the American City, MIT Press, 2008

- Bill Loomis, 1900-1930: The years of driving dangerously, The Detroit News, 26.4.2015

- Iyad Rahwan, What Moral Decisions Should Driverless Cars Make?, Ted Talks, September 2016

- Jonathan Erhardt, The Ethics of Self-Driving Cars, Crucial Considerations, 13. Januar 2016

- Lorena Jaume-Palasí, Por qué no hay que tener miedo de la inteligencia artificial, El País, 18. März 2018

- Bundesministerium für Verkehr und digitale Infrastruktur, Bericht der Ethik-Kommission: Automatisiertes und vernetztes Fahren, Juni 2017

Zur Übersicht aller bisherigen Texte der Reihe »Understanding Digital Capitalism«.